Neuigkeiten

15/01/2021

Ihr Rechenzentrum als Data Center as a Service

Die Digitalisierung schafft Möglichkeiten, der Mensch muss daraus etwas machen.

Auf Basis dieser Erkenntnis bieten wir Ihnen die Möglichkeit sich auf Ihr Kerngeschäft zu fokussieren, während wir Ihnen einen reibungslosen Rechenzentrumsbetrieb sicherstellen.

Wir modernisieren Ihr Rechenzentrum lokal an Ihrem Standort und betreiben die Infrastruktur ganzheitlich. Mit einer systemgestützten Fernüberwachung können wir aus der Ferne alle relevanten Betriebsfaktoren überprüfen. Unser rund um die Uhr besetztes Monitoringcenter nimmt auftretende Störungsmeldungen entgegen und kann dann mit im Vorfeld festgelegten Reaktionszeiten auf Zwischenfälle reagieren - entweder per Fernsteuerung der Komponenten oder mit Systemtechnikern vor Ort nach Bedarf.

Neben dem Incident Management umfasst unser Wartungsprogramm alle Produkte Ihres Rechenzentrums. Im festgelegten Turnus werden alle betriebsrelevanten Teile überprüft und Verschleißteile entsprechend den Herstellervorgaben gewartet bzw. ersetzt. Unsere Techniker werden dabei regelmäßig geschult und zertifiziert, so dass jederzeit für den aktuellsten Stand der Technik und die Sicherheit Ihrer IT-Infrastruktur gesorgt ist.

Zu einer preisgekrönt höchsteffizienten IT-Infrastruktur haben Sie mit unserem Data Center as a Service auch alle weiteren Kostenvorteile in der Hand. So können Sie bestehende Reserveflächen nutzen und von günstigen lokalen Energiekosten profitieren. Und im Gegensatz zu einer Cloud Lösung fallen keine erhöhten Netzwerkkosten an. Somit können Sie frei gewordene Kapazitäten effektiv nutzen und dabei auch Kosten einsparen.

Ergänzend zur Effizienz bietet das innovIT DCaaS auch zertifizierte Sicherheit. Neben einer TÜV Zertifizierung nach ISO 27001 und EN 50600 bieten unsere multiredundanten Lösungen die umfassendste technische und physikalische Sicherheit am Markt.

Doch nebst der Sicherheit und Effizienz ist insbesondere Skalierbarkeit wichtig, um auf die schnell wechselnden Anforderungen einer digitalisierten Welt zu reagieren. Um optimal auf Veränderungen zu reagieren bietet unser Data Center as a Service Konzept eine freie Skalierung der Kapazitäten in nur 8 Wochen an.

Nutzen Sie damit die Möglichkeit, Digitalisierung zu gestalten. In Ihrem Sinne - mit Ihren Möglichkeiten. Und mit einem Rechenzentrum, das Ihnen alle Möglichkeiten für die Zukunft bietet.

Ihr Rechenzentrum als Data Center as a Service

Die Digitalisierung schafft Möglichkeiten, der Mensch muss daraus etwas machen.

Auf Basis dieser Erkenntnis bieten wir Ihnen die Möglichkeit sich auf Ihr Kerngeschäft zu fokussieren, während wir Ihnen einen reibungslosen Rechenzentrumsbetrieb sicherstellen.

Wir modernisieren Ihr Rechenzentrum lokal an Ihrem Standort und betreiben die Infrastruktur ganzheitlich. Mit einer systemgestützten Fernüberwachung können wir aus der Ferne alle relevanten Betriebsfaktoren überprüfen. Unser rund um die Uhr besetztes Monitoringcenter nimmt auftretende Störungsmeldungen entgegen und kann dann mit im Vorfeld festgelegten Reaktionszeiten auf Zwischenfälle reagieren - entweder per Fernsteuerung der Komponenten oder mit Systemtechnikern vor Ort nach Bedarf.

Neben dem Incident Management umfasst unser Wartungsprogramm alle Produkte Ihres Rechenzentrums. Im festgelegten Turnus werden alle betriebsrelevanten Teile überprüft und Verschleißteile entsprechend den Herstellervorgaben gewartet bzw. ersetzt. Unsere Techniker werden dabei regelmäßig geschult und zertifiziert, so dass jederzeit für den aktuellsten Stand der Technik und die Sicherheit Ihrer IT-Infrastruktur gesorgt ist.

Zu einer preisgekrönt höchsteffizienten IT-Infrastruktur haben Sie mit unserem Data Center as a Service auch alle weiteren Kostenvorteile in der Hand. So können Sie bestehende Reserveflächen nutzen und von günstigen lokalen Energiekosten profitieren. Und im Gegensatz zu einer Cloud Lösung fallen keine erhöhten Netzwerkkosten an. Somit können Sie frei gewordene Kapazitäten effektiv nutzen und dabei auch Kosten einsparen.

Ergänzend zur Effizienz bietet das innovIT DCaaS auch zertifizierte Sicherheit. Neben einer TÜV Zertifizierung nach ISO 27001 und EN 50600 bieten unsere multiredundanten Lösungen die umfassendste technische und physikalische Sicherheit am Markt.

Doch nebst der Sicherheit und Effizienz ist insbesondere Skalierbarkeit wichtig, um auf die schnell wechselnden Anforderungen einer digitalisierten Welt zu reagieren. Um optimal auf Veränderungen zu reagieren bietet unser Data Center as a Service Konzept eine freie Skalierung der Kapazitäten in nur 8 Wochen an.

Nutzen Sie damit die Möglichkeit, Digitalisierung zu gestalten. In Ihrem Sinne - mit Ihren Möglichkeiten. Und mit einem Rechenzentrum, das Ihnen alle Möglichkeiten für die Zukunft bietet.

24/04/2018

Deutscher Rechenzentrumspreis: innovIT360 AG doppelt ausgezeichnet

Mit vollem Stolz durfte die innovIT360 AG am 24. April in Darmstadt gleich zwei Auszeichnungen im Rahmen der Verleihung des deutschen Rechenzentrumspreises im Empfang nehmen.

Als Sieger in der Kategorie 7: „Gesamtheitliche IT und FM-Projekte im Rechenzentrum“ setzte sich das integrierte Edge Rechenzentrum als intelligent Datacenter as a Service (iDCaaS) der innovIT360 AG gegen starke Wettbewerber durch.

Einen ebenfalls starken Platz 2 erreichte die innovIT360 AG in der Kategorie 6: „Energieeffizienzsteigerung durch Umbau in einem Bestandsrechenzentrum“ mit der Errichtung eines internationalen Cloud Hubs mit modularer Rechenzentrumsinfrastruktur.

„Als einzige Firma sogar in zwei Kategorien dieser anerkannten Veranstaltung ausgezeichnet zu werden, macht uns als noch junges Unternehmen besonders stolz“ so Frank Zachmann, Vorstand der innovIT360 AG. Jörg Tennigkeit, Vorstandsvorsitzender der innovIT AG, ergänzt: „Nach dem Gewinn des deutschen Rechenzentrumspreises durch die innovIT AG im letzten Jahr zeigt diese Auszeichnung, welches innovative Potenzial in den Produkten und Services der innovIT Gruppe liegt und wie anerkannte Experten dieses beurteilen.“ „Wir hatten uns im vergangenen Jahr vorgenommen, die ausgezeichneten Produkte der innovIT AG mit hochwertigen Services zu veredeln“ ergänzt Zachmann. „Die im Trend liegenden Anforderungen nach flexiblen und effizienten Edge- und Cloud Services schaffen Nachfrage, wir bieten Lösungen.“

Deutscher Rechenzentrumspreis: innovIT360 AG doppelt ausgezeichnet

Mit vollem Stolz durfte die innovIT360 AG am 24. April in Darmstadt gleich zwei Auszeichnungen im Rahmen der Verleihung des deutschen Rechenzentrumspreises im Empfang nehmen.

Als Sieger in der Kategorie 7: „Gesamtheitliche IT und FM-Projekte im Rechenzentrum“ setzte sich das integrierte Edge Rechenzentrum als intelligent Datacenter as a Service (iDCaaS) der innovIT360 AG gegen starke Wettbewerber durch.

Einen ebenfalls starken Platz 2 erreichte die innovIT360 AG in der Kategorie 6: „Energieeffizienzsteigerung durch Umbau in einem Bestandsrechenzentrum“ mit der Errichtung eines internationalen Cloud Hubs mit modularer Rechenzentrumsinfrastruktur.

„Als einzige Firma sogar in zwei Kategorien dieser anerkannten Veranstaltung ausgezeichnet zu werden, macht uns als noch junges Unternehmen besonders stolz“ so Frank Zachmann, Vorstand der innovIT360 AG. Jörg Tennigkeit, Vorstandsvorsitzender der innovIT AG, ergänzt: „Nach dem Gewinn des deutschen Rechenzentrumspreises durch die innovIT AG im letzten Jahr zeigt diese Auszeichnung, welches innovative Potenzial in den Produkten und Services der innovIT Gruppe liegt und wie anerkannte Experten dieses beurteilen.“ „Wir hatten uns im vergangenen Jahr vorgenommen, die ausgezeichneten Produkte der innovIT AG mit hochwertigen Services zu veredeln“ ergänzt Zachmann. „Die im Trend liegenden Anforderungen nach flexiblen und effizienten Edge- und Cloud Services schaffen Nachfrage, wir bieten Lösungen.“

13/04/2018

IoT - Innovationen, Hindernisse & Trends

Frank Zachmann von innovIT360 erläutert die infrastrukturellen Herausforderungen für die Entwicklung der Innovationskraft des Internets der Dinge und bietet eine Lösung für die Zukunft der digitalen Infrastruktur.

Wird das Internet der Dinge die Welt zum Besseren verändern? Ja, zweifellos!

Aber: Wann und wie genau hängt noch von einer Vielzahl von Einflussfaktoren ab.

Und wie können wir als IT bzw. Telekommunikationsindustrie dazu beitragen, gute Ideen zum Leben zu erwecken?

Dieser Artikel wählt nur einen Beispielfall eines B2C-bezogenen Aspekts des IoT aus, um zu untersuchen, wie die Innovationen der modernen Technologie selbst mit Hindernissen konfrontiert sind und um uns dabei zu helfen, zu erkennen, wie eine Lösung aussehen könnte.

Worauf achten wir konkret? Hier untersuchen wir den Fall des möglicherweise oft gehörten intelligenten Strom-Power-Managements zu Hause. Oder um es noch weiter zu detailieren: Die intelligente Waschmaschine, der intelligente Stromleser und wie der Stromversorger versucht ein Interessengleichgewicht zu schaffen. Hört sich interessant an? Hier ist die Geschichte.

Mit intelligenten Waschmaschinen ein Interessenausgleich schaffen

Destatis.de berichtet, dass 96,4% der 37,3 Millionen Haushalte in Deutschland eine Waschmaschine besitzen. Das sind rund 36 Millionen Waschmaschinen in Deutschland. Bei einem Strombedarf von ca. 1 kWh pro Waschgang ergibt sich daraus ein Gesamtleistungsbedarf für Waschmaschinen in Deutschland von ca. 4% des gesamten deutschen privaten Stromverbrauchs (www.oeko.de). Basierend auf einer älteren Statistik aus dem Jahr 2006 bedeutet das etwa 140 kWh pro Haushalt / Jahr. Seitdem sind die Strompreise von rund 20 auf fast 30 Ct./kWh gestiegen. Das sind 42 Euro pro Haushalt und insgesamt 1,5 Milliarden Euro insgesamt.

Aber wie verhält es sich mit dem oben erwähnten IoT? Moderne Maschinen können natürlich bessere, effizientere Waschprogramme verwenden und den Energieverbrauch senken. Außerdem können die Waschtemperaturen mit einer Art linearem Effekt auf die Kosten / Effizienz reduziert werden.

Aber was ist mit den folgenden einfachen Mathematik? Stellen Sie sich vor, ein moderner intelligenter Leistungsmesser misst den Stromverbrauch in einem privaten Haushalt und liest das Waschmuster aus. Stellen Sie sich vor, dass dieser Leser auf beide Arten kommuniziert: Er würde dem Stromversorger den genauen Bedarf an Strom liefern, wann und wie viel Strom benötigt wird. Mit Hilfe einer interdependenten Verbindung zwischen Endverbraucher und Energieversorger könnte eine Reduzierung der Strompreise um 3-5% realisiert werden. Wir sind auf einige Stromanbieter gestoßen, die diese Daten nutzen möchten und die in Erwägung ziehen würden, ihren Kunden intelligente Datentarife anzubietet. Dies bedeutet, das Smart-Grid-Konzept könnte helfen die Stromnachfrage und -preise in Relation zur realen Nachfrage zu steuern um das Potenzial des Internets der Dinge zu nutzen. Setzt der Stromanbieter den Besonderen - nennen wir es einen "Waschtarif" - zum Beispiel nachts an, könnte der Stromzähler den Start des nächsten Waschprogramms an die Maschine signalisieren. Dadurch könnten die Strompreise um 3-5% reduziert werden. Also 5% von 42 Euro pro Jahr mögen langweilig klingen, aber was ist mit 5% von 1,5 Mrd.? Euro = 75 Mio. Euro? Und dies ist nur ein kleiner Teilaspekt der besseren Nutzung von Ressourcen durch IoT.

Das klingt ziemlich einfach und es wird nicht viel Brain-Power benötigt, um das Konzept theoretisch laufen zu lassen. Hurra zu den Segnungen der Innovation. Aber was ist mit dem "Hindernis" - dem "O" in dieser Interpretation des Internet der Dinge (IoT)?

Ein kürzlich stattgefundenes Gespräch mit einem Senior Analyst eines der vier großen Stromanbieter in Deutschland hat die Aufmerksamkeit des Autors auf sich gezogen, insbesondere einen Kommentar: "(...) wir haben einfach nicht die (technische) Bandbreite". Als er mit ihm über die Fülle von Ideen sprach, die die Runde in Bezug auf neue, durch Technologie ermöglichte Innovationen machten, erzählte er mir von einem Forschungsprojekt, das der Stromanbieter unternahm, um sowohl eine Machbarkeitsstudie als auch eine Preisliste von Innovationen zu veröffentlichen. Während viele weitere gute Ideen untersucht wurden, die über das hier verwendete einfache Beispiel hinausgehen, lernte der Energieversorger die theoretisch einfache, aber sehr wichtige Problematik kennen: die digitale Infrastruktur. "Wir haben weder die Telekommunikationsbandbreite, um die Daten zu transportieren, noch sind unsere Rechenzentrumsfähigkeiten ausreichend, um die Daten tatsächlich zu analysieren", sagte der Analyst. Oder um es auf den Punkt zu bringen: "Mit den derzeitigen Infrastrukturkapazitäten sind wir nicht in der Lage, mehr als 3 Tage an Kundendaten zu messen, zu transportieren und zu analysieren." (!)

Angesichts der Möglichkeiten neuer Sensoren und der stetig wachsenden Anzahl intelligenter "Dinge" im IoT, die wir in Zukunft sehen werden, haben wir gerade gelernt, dass es nicht genug "Backend" -Fähigkeit gibt Eine Infrastruktur, um die Anforderungen von IoT zu erfüllen

Hier kommt das "T" nach der "Innovation" und den "Hindernissen". Der Trend zum Edge-Computing und eine Veränderung des gesamten Netzwerkdenkens, welcher nötig ist um alle Aspekte der schnellen Datenerhebung und -nutzung (Analytik und anschließende Reaktion) zu bewältigen. All dies muss dezentral erfolgen und damit weder über WAN-Netze transportiert noch in dedizierten zentralen Rechenzentren verarbeitet werden.

Wir müssen das Netzwerk zu den Daten bringen, nicht umgekehrt - das bedeutet sowohl große Datennetze wie 5G und Glasfaser für den Datentransport als auch verteilte Mikrodatenzentren für die Datenverarbeitung. Werfen wir unseren Blick auf eine andere Geschichte: Eine aktuelle Studie zum vernetzten autonomen Fahren kam zu dem Schluss, dass für die effiziente Handhabung der kritischen Datenmengen eine Art Datenverarbeitungseinheit installiert werden müsste nicht mehr als 15 km Radius. Wenn wir dies sowohl auf unseren Beispielfall als auch auf unsere allgemeine Diskussion anwenden, würde dies bedeuten: Wir müssen das Netzwerk zu den Daten bringen, nicht umgekehrt. Und Netzwerk bedeutet sowohl hochvolumige Datennetze wie 5G und Glasfaser für den Datentransport, als auch verteilte Mikrodatenzentren für die Datenverarbeitung.

Genau an dieser Frage arbeitet innovIT360 und redet sowohl mit Immobilienbesitzern als auch mit der Energiewirtschaft darüber, wie dies am effizientesten erreicht werden kann. Warum sollten Multi-Tenant-Immobilienentwicklungen kein eigenes kleines Mikrodatenzentrum haben und als zentrale Verarbeitungsressource im "IoT-Grid" fungieren? Ein intelligenter DC als Dienst, der Analysen von Energiebedarf, Telekommunikation und Cloud-Hub für andere zentrale Dienste und andere durchführen könnte? Wir sehen dies als einen zentralen Trend des sogenannten "Edge": Wir bringen das Netzwerk und die Rechenleistung in die Daten. Um das "O" im IoT zu überwinden - damit die IT funktioniert.

IoT - Innovationen, Hindernisse & Trends

Frank Zachmann von innovIT360 erläutert die infrastrukturellen Herausforderungen für die Entwicklung der Innovationskraft des Internets der Dinge und bietet eine Lösung für die Zukunft der digitalen Infrastruktur.

Wird das Internet der Dinge die Welt zum Besseren verändern? Ja, zweifellos!

Aber: Wann und wie genau hängt noch von einer Vielzahl von Einflussfaktoren ab.

Und wie können wir als IT bzw. Telekommunikationsindustrie dazu beitragen, gute Ideen zum Leben zu erwecken?

Dieser Artikel wählt nur einen Beispielfall eines B2C-bezogenen Aspekts des IoT aus, um zu untersuchen, wie die Innovationen der modernen Technologie selbst mit Hindernissen konfrontiert sind und um uns dabei zu helfen, zu erkennen, wie eine Lösung aussehen könnte.

Worauf achten wir konkret? Hier untersuchen wir den Fall des möglicherweise oft gehörten intelligenten Strom-Power-Managements zu Hause. Oder um es noch weiter zu detailieren: Die intelligente Waschmaschine, der intelligente Stromleser und wie der Stromversorger versucht ein Interessengleichgewicht zu schaffen. Hört sich interessant an? Hier ist die Geschichte.

Mit intelligenten Waschmaschinen ein Interessenausgleich schaffen

Destatis.de berichtet, dass 96,4% der 37,3 Millionen Haushalte in Deutschland eine Waschmaschine besitzen. Das sind rund 36 Millionen Waschmaschinen in Deutschland. Bei einem Strombedarf von ca. 1 kWh pro Waschgang ergibt sich daraus ein Gesamtleistungsbedarf für Waschmaschinen in Deutschland von ca. 4% des gesamten deutschen privaten Stromverbrauchs (www.oeko.de). Basierend auf einer älteren Statistik aus dem Jahr 2006 bedeutet das etwa 140 kWh pro Haushalt / Jahr. Seitdem sind die Strompreise von rund 20 auf fast 30 Ct./kWh gestiegen. Das sind 42 Euro pro Haushalt und insgesamt 1,5 Milliarden Euro insgesamt.

Aber wie verhält es sich mit dem oben erwähnten IoT? Moderne Maschinen können natürlich bessere, effizientere Waschprogramme verwenden und den Energieverbrauch senken. Außerdem können die Waschtemperaturen mit einer Art linearem Effekt auf die Kosten / Effizienz reduziert werden.

Aber was ist mit den folgenden einfachen Mathematik? Stellen Sie sich vor, ein moderner intelligenter Leistungsmesser misst den Stromverbrauch in einem privaten Haushalt und liest das Waschmuster aus. Stellen Sie sich vor, dass dieser Leser auf beide Arten kommuniziert: Er würde dem Stromversorger den genauen Bedarf an Strom liefern, wann und wie viel Strom benötigt wird. Mit Hilfe einer interdependenten Verbindung zwischen Endverbraucher und Energieversorger könnte eine Reduzierung der Strompreise um 3-5% realisiert werden. Wir sind auf einige Stromanbieter gestoßen, die diese Daten nutzen möchten und die in Erwägung ziehen würden, ihren Kunden intelligente Datentarife anzubietet. Dies bedeutet, das Smart-Grid-Konzept könnte helfen die Stromnachfrage und -preise in Relation zur realen Nachfrage zu steuern um das Potenzial des Internets der Dinge zu nutzen. Setzt der Stromanbieter den Besonderen - nennen wir es einen "Waschtarif" - zum Beispiel nachts an, könnte der Stromzähler den Start des nächsten Waschprogramms an die Maschine signalisieren. Dadurch könnten die Strompreise um 3-5% reduziert werden. Also 5% von 42 Euro pro Jahr mögen langweilig klingen, aber was ist mit 5% von 1,5 Mrd.? Euro = 75 Mio. Euro? Und dies ist nur ein kleiner Teilaspekt der besseren Nutzung von Ressourcen durch IoT.

Das klingt ziemlich einfach und es wird nicht viel Brain-Power benötigt, um das Konzept theoretisch laufen zu lassen. Hurra zu den Segnungen der Innovation. Aber was ist mit dem "Hindernis" - dem "O" in dieser Interpretation des Internet der Dinge (IoT)?

Ein kürzlich stattgefundenes Gespräch mit einem Senior Analyst eines der vier großen Stromanbieter in Deutschland hat die Aufmerksamkeit des Autors auf sich gezogen, insbesondere einen Kommentar: "(...) wir haben einfach nicht die (technische) Bandbreite". Als er mit ihm über die Fülle von Ideen sprach, die die Runde in Bezug auf neue, durch Technologie ermöglichte Innovationen machten, erzählte er mir von einem Forschungsprojekt, das der Stromanbieter unternahm, um sowohl eine Machbarkeitsstudie als auch eine Preisliste von Innovationen zu veröffentlichen. Während viele weitere gute Ideen untersucht wurden, die über das hier verwendete einfache Beispiel hinausgehen, lernte der Energieversorger die theoretisch einfache, aber sehr wichtige Problematik kennen: die digitale Infrastruktur. "Wir haben weder die Telekommunikationsbandbreite, um die Daten zu transportieren, noch sind unsere Rechenzentrumsfähigkeiten ausreichend, um die Daten tatsächlich zu analysieren", sagte der Analyst. Oder um es auf den Punkt zu bringen: "Mit den derzeitigen Infrastrukturkapazitäten sind wir nicht in der Lage, mehr als 3 Tage an Kundendaten zu messen, zu transportieren und zu analysieren." (!)

Angesichts der Möglichkeiten neuer Sensoren und der stetig wachsenden Anzahl intelligenter "Dinge" im IoT, die wir in Zukunft sehen werden, haben wir gerade gelernt, dass es nicht genug "Backend" -Fähigkeit gibt Eine Infrastruktur, um die Anforderungen von IoT zu erfüllen

Hier kommt das "T" nach der "Innovation" und den "Hindernissen". Der Trend zum Edge-Computing und eine Veränderung des gesamten Netzwerkdenkens, welcher nötig ist um alle Aspekte der schnellen Datenerhebung und -nutzung (Analytik und anschließende Reaktion) zu bewältigen. All dies muss dezentral erfolgen und damit weder über WAN-Netze transportiert noch in dedizierten zentralen Rechenzentren verarbeitet werden.

Wir müssen das Netzwerk zu den Daten bringen, nicht umgekehrt - das bedeutet sowohl große Datennetze wie 5G und Glasfaser für den Datentransport als auch verteilte Mikrodatenzentren für die Datenverarbeitung. Werfen wir unseren Blick auf eine andere Geschichte: Eine aktuelle Studie zum vernetzten autonomen Fahren kam zu dem Schluss, dass für die effiziente Handhabung der kritischen Datenmengen eine Art Datenverarbeitungseinheit installiert werden müsste nicht mehr als 15 km Radius. Wenn wir dies sowohl auf unseren Beispielfall als auch auf unsere allgemeine Diskussion anwenden, würde dies bedeuten: Wir müssen das Netzwerk zu den Daten bringen, nicht umgekehrt. Und Netzwerk bedeutet sowohl hochvolumige Datennetze wie 5G und Glasfaser für den Datentransport, als auch verteilte Mikrodatenzentren für die Datenverarbeitung.

Genau an dieser Frage arbeitet innovIT360 und redet sowohl mit Immobilienbesitzern als auch mit der Energiewirtschaft darüber, wie dies am effizientesten erreicht werden kann. Warum sollten Multi-Tenant-Immobilienentwicklungen kein eigenes kleines Mikrodatenzentrum haben und als zentrale Verarbeitungsressource im "IoT-Grid" fungieren? Ein intelligenter DC als Dienst, der Analysen von Energiebedarf, Telekommunikation und Cloud-Hub für andere zentrale Dienste und andere durchführen könnte? Wir sehen dies als einen zentralen Trend des sogenannten "Edge": Wir bringen das Netzwerk und die Rechenleistung in die Daten. Um das "O" im IoT zu überwinden - damit die IT funktioniert.

17/03/2018

innovIT als Partner des Systemauskongresses 2018 in Düsseldorf

Unter dem Motto „ Die Digitale Transformation meistern“ steht der diesjährige Systemhauskongress der vom 27.-28.9.2018 in Düsseldorf stattfinden wird. Als starker Partner für Systemhäuser, Service Provider und IT-Dienstleister sind wir als Aussteller auf dem Kongress mit einem eigenen Team vertreten. Dort zeigen wir unter anderem unsere innovativen und effizienten Rechenzentrumslösungen.

Hochkarätige Referenten werden interessante und spannende Vorträge u.a. zu den Themen Managed Services und Security halten. Eine Preisverleihung auf der Abendgala für z.B. den „Newcomer des Jahres", oder der „Aufsteiger des Jahres“, runden das Programm standesgemäß ab. Wir freuen uns auf diese hochkarätige Veranstaltung sowie auf interessante und zukunftsweisende Gespräche.

innovIT als Partner des Systemauskongresses 2018 in Düsseldorf

Unter dem Motto „ Die Digitale Transformation meistern“ steht der diesjährige Systemhauskongress der vom 27.-28.9.2018 in Düsseldorf stattfinden wird. Als starker Partner für Systemhäuser, Service Provider und IT-Dienstleister sind wir als Aussteller auf dem Kongress mit einem eigenen Team vertreten. Dort zeigen wir unter anderem unsere innovativen und effizienten Rechenzentrumslösungen.

Hochkarätige Referenten werden interessante und spannende Vorträge u.a. zu den Themen Managed Services und Security halten. Eine Preisverleihung auf der Abendgala für z.B. den „Newcomer des Jahres", oder der „Aufsteiger des Jahres“, runden das Programm standesgemäß ab. Wir freuen uns auf diese hochkarätige Veranstaltung sowie auf interessante und zukunftsweisende Gespräche.

10/02/2018

Die Deutsche Rechenzentrumsmanufaktur auf der Cebit 2018

innovIT ist der Spezialist für innovative, modulare und hocheffiziente Rechenzentrumslösungen. Ein erfahrenes Expertenteam plant, baut und betreut Rechenzentren verschiedener Größen. Die smarten EDGE-Datacenter Lösungen von innovIT (innoSAFE) bieten hocheffizienten Schutz Ihrer IT-Komponenten für kleine bis mittlere Rechenzentren. Unsere flexiblen Raum-in-Raum-Lösungen, sowie unsere Modul-Rechenzentren (innoMDC) runden unser Portfolio in alle Richtungen entsprechend ab.

Zusätzlich stellen wir auf der CeBIT unser Konzept DC Complete vor, unsere vollintegrierte Hybrid-Cloud Lösung basierend auf unseren leistungsstarken und flexiblen EDGE-Datacenter-Lösungen. Wir liefern Ihnen alle Leistungen aus einer Hand.

Kommen Sie gerne auf uns zu. Wir sind für Sie da! Halle 12 D132

Die Deutsche Rechenzentrumsmanufaktur auf der Cebit 2018

innovIT ist der Spezialist für innovative, modulare und hocheffiziente Rechenzentrumslösungen. Ein erfahrenes Expertenteam plant, baut und betreut Rechenzentren verschiedener Größen. Die smarten EDGE-Datacenter Lösungen von innovIT (innoSAFE) bieten hocheffizienten Schutz Ihrer IT-Komponenten für kleine bis mittlere Rechenzentren. Unsere flexiblen Raum-in-Raum-Lösungen, sowie unsere Modul-Rechenzentren (innoMDC) runden unser Portfolio in alle Richtungen entsprechend ab.

Zusätzlich stellen wir auf der CeBIT unser Konzept DC Complete vor, unsere vollintegrierte Hybrid-Cloud Lösung basierend auf unseren leistungsstarken und flexiblen EDGE-Datacenter-Lösungen. Wir liefern Ihnen alle Leistungen aus einer Hand.

Kommen Sie gerne auf uns zu. Wir sind für Sie da! Halle 12 D132

26/01/2018

IOT als Treiber für Datenwachstum - und als Grund für neue Infrastrukturlösungen.

Ein Beispielfall und eine Aussage zur modularen Edge Erweiterung des Internets.

Im Zeitalter der Smartphones und des endlosen Datenstroms, der durch die unzähligen Apps erzeugt wird, ist einer der größten Datenmengentreiber jedoch das Internet der Dinge, auch bekannt als IOT. Und welches "Ding" könnte besser als Beispiel einer "stillen Datensammlung" geeignet sein als das Auto.

Hier sind die Gründe: Viele von uns benutzen das Auto täglich und wir haben eine Vorstellung davon, wie oft und wie weit wir es fahren. Zum Beispiel beträgt die durchschnittliche jährliche Laufleistung in Deutschland etwa 14.200 km pro Jahr. Und wir sind uns der Folgen des Autofahrens bei Themen wie dem CO2-Fußabdruck bewußt.

Aber wie sieht der "Daten-Fußabdruck" eines modernen Autos aus? Und wie gehen wir mit diesen Daten um - nicht im Bezug auf den Datenschutz, sondern hinsichtlich der technischen Aspekte. Wie kann diese Datenmenge heute und in Zukunft am effizientesten verabeitet werden.

Intelligente Autos sammeln bereits heute Daten auf breiter Basis: Fahrprofile, Wartungsdaten und modernste Assistenzfunktionen führen zu durchschnittlich 1 GB Daten pro Sekunde in jedem Auto. Der Großteil davon wird von videobasierten Systemen erzeugt. Diese werden genutzt, um Autos teilweise autonom fahren lassen zu können. Dies deutet darauf hin, dass die Datenmenge noch weiter zunehmen wird, insbesondere mit den zusätzlichen Möglichkeiten und der zunehmenden Komplexität am Horizont. Mit Blick auf die Automobilindustrie sprechen wir von einem Faktor von bis zu x20 für die Zukunft, so dass wir im Zeitalter des autonomen Fahrens insgesamt 50 Terabyte Daten pro Auto und Tag erleben werden.

Was wäre, wenn wir versuchen würden, diese Zahlen auf die heutigen Autos in Deutschland (46,5 Millionen) hochzurechnen? Bei einer Durchschnittsgeschwindigkeit von 60 km/h ergeben sich aus den 14.200 km pro Jahr "nur" 852.000 Sekunden Fahrzeit oder ein Äquivalent von 852 Terabyte (das entspricht 0,85 Petabyte) pro Jahr. Dies entspricht einem Durchschnitt von 2,3 Terabyte pro Tag und damit ungefähr dem Faktor von x21, um in Zukunft auf die erwarteten 50 Terabyte pro Tag zu kommen. Aber das ist nur ein (!) Auto. Multipliziert mit 46,5 Mio. Autos allein in Deutschland ergibt sich heute ein aktuelles Datenvolumen von bis zu 40 Zettabyte pro Jahr oder 848 Zettabyte in der Zukunft. Das nähert sich 0,85 Yottabyte - willkommen auf der nächsten Ebene der großen Datenvolumen: Ein Yottabyte sind 10 * 24 Bytes (100000000000000000000000000 zu Vorstellung).

Zu viel Zahlenakrobatik und ein bisschen zu viel von Bytes? Anders übersetzt: Moderne Autos sind eine Art Rechenzentrum für sich - sie haben eine Rechenleistung von mehr als 100 CPUs und müssen Daten innerhalb von Millisekunden validieren, bevor sie die Ergebnisse nicht nur an ihre internen Fahrsysteme senden, sondern auch mit anderen Fahrzeugen auf der Straße kommunizieren.

Die größte Testflotte von autonomen Autos ist die von Tesla. Diese hat aktuell "nur" ungefähr Daten von 1 Milliarde Kilometer autonomen Fahrens gesammelt. Der jüngste erste Todesfall durch ein autonomes Fahrzeug zeigt die Notwendigkeit einer vorausschauenderen Verkehrsbeobachtung durch das Auto, was noch mehr Datenerfassung und schnellere Validierung bedeutet. Und mehr zu transportierende Daten.

Wird 5G die Antwort sein? Nein. Wenn die Datenmenge wie oben beschrieben explodiert, besteht ein klarer Bedarf an effizienten Datenverarbeitungssystemen, die sowohl kosten- als auch netzwerkeffizient sind. Eine kürzlich durchgeführte Studie kam zu dem Schluss, dass auch unter Berücksichtigung von Latenzaspekten und Sicherheit, innerhalb von 15 Kilometern Entfernung eine kleine lokale "Datenverarbeitungseinheit (DVU)" installiert werden müsste, um die Daten auf möglichst effiziente Weise zu übertragen und zu validieren. Dies ist jedoch mit der traditionellen Netzwerk- und Rechenzentrums-Infrastruktur nicht möglich. Somit wird sich das "Internet" erneut erweitern müssen, hin zur Edge.

Stellen Sie sich eine Stand-Alone-Einheit vor, die in puncto Leistung, Kühlung und Konnektivität voll ausgestattet ist. Und sowohl Portabel als auch vorbereitet für den Plug & Play Betrieb in öffentlichen Stromversorgungs- und Netzwerkinfrastrukturen ist. Das autonome Fahren ist damit der Beispiel-Anwendungsfall für die nächste Generation kleiner modularer Rechenzentren, in kurzer Distanz wie dem angegebenen 15 Kilometer Radius, kombiniert mit Antennentechnologie für die Car2Cell-Kommunikation. Zwar gibt es bereits einige Hersteller, die Hardware für diese Infrastruktur anbieten, doch der nächste logische Schritt ist die Bereitstellung voll ausgestatteter DVUs auf einer Pay-per-Use-Basis. Gegenwärtig sind diese felxiblen Infrastrukturmodule, bis zu einer Kapazität von 3 Petabyte pro Einheit, von der innovIT360 AG bereits verfügbar. Fragen Sie uns ...

IOT als Treiber für Datenwachstum - und als Grund für neue Infrastrukturlösungen.

Ein Beispielfall und eine Aussage zur modularen Edge Erweiterung des Internets.

Im Zeitalter der Smartphones und des endlosen Datenstroms, der durch die unzähligen Apps erzeugt wird, ist einer der größten Datenmengentreiber jedoch das Internet der Dinge, auch bekannt als IOT. Und welches "Ding" könnte besser als Beispiel einer "stillen Datensammlung" geeignet sein als das Auto.

Hier sind die Gründe: Viele von uns benutzen das Auto täglich und wir haben eine Vorstellung davon, wie oft und wie weit wir es fahren. Zum Beispiel beträgt die durchschnittliche jährliche Laufleistung in Deutschland etwa 14.200 km pro Jahr. Und wir sind uns der Folgen des Autofahrens bei Themen wie dem CO2-Fußabdruck bewußt.

Aber wie sieht der "Daten-Fußabdruck" eines modernen Autos aus? Und wie gehen wir mit diesen Daten um - nicht im Bezug auf den Datenschutz, sondern hinsichtlich der technischen Aspekte. Wie kann diese Datenmenge heute und in Zukunft am effizientesten verabeitet werden.

Intelligente Autos sammeln bereits heute Daten auf breiter Basis: Fahrprofile, Wartungsdaten und modernste Assistenzfunktionen führen zu durchschnittlich 1 GB Daten pro Sekunde in jedem Auto. Der Großteil davon wird von videobasierten Systemen erzeugt. Diese werden genutzt, um Autos teilweise autonom fahren lassen zu können. Dies deutet darauf hin, dass die Datenmenge noch weiter zunehmen wird, insbesondere mit den zusätzlichen Möglichkeiten und der zunehmenden Komplexität am Horizont. Mit Blick auf die Automobilindustrie sprechen wir von einem Faktor von bis zu x20 für die Zukunft, so dass wir im Zeitalter des autonomen Fahrens insgesamt 50 Terabyte Daten pro Auto und Tag erleben werden.

Was wäre, wenn wir versuchen würden, diese Zahlen auf die heutigen Autos in Deutschland (46,5 Millionen) hochzurechnen? Bei einer Durchschnittsgeschwindigkeit von 60 km/h ergeben sich aus den 14.200 km pro Jahr "nur" 852.000 Sekunden Fahrzeit oder ein Äquivalent von 852 Terabyte (das entspricht 0,85 Petabyte) pro Jahr. Dies entspricht einem Durchschnitt von 2,3 Terabyte pro Tag und damit ungefähr dem Faktor von x21, um in Zukunft auf die erwarteten 50 Terabyte pro Tag zu kommen. Aber das ist nur ein (!) Auto. Multipliziert mit 46,5 Mio. Autos allein in Deutschland ergibt sich heute ein aktuelles Datenvolumen von bis zu 40 Zettabyte pro Jahr oder 848 Zettabyte in der Zukunft. Das nähert sich 0,85 Yottabyte - willkommen auf der nächsten Ebene der großen Datenvolumen: Ein Yottabyte sind 10 * 24 Bytes (100000000000000000000000000 zu Vorstellung).

Zu viel Zahlenakrobatik und ein bisschen zu viel von Bytes? Anders übersetzt: Moderne Autos sind eine Art Rechenzentrum für sich - sie haben eine Rechenleistung von mehr als 100 CPUs und müssen Daten innerhalb von Millisekunden validieren, bevor sie die Ergebnisse nicht nur an ihre internen Fahrsysteme senden, sondern auch mit anderen Fahrzeugen auf der Straße kommunizieren.

Die größte Testflotte von autonomen Autos ist die von Tesla. Diese hat aktuell "nur" ungefähr Daten von 1 Milliarde Kilometer autonomen Fahrens gesammelt. Der jüngste erste Todesfall durch ein autonomes Fahrzeug zeigt die Notwendigkeit einer vorausschauenderen Verkehrsbeobachtung durch das Auto, was noch mehr Datenerfassung und schnellere Validierung bedeutet. Und mehr zu transportierende Daten.

Wird 5G die Antwort sein? Nein. Wenn die Datenmenge wie oben beschrieben explodiert, besteht ein klarer Bedarf an effizienten Datenverarbeitungssystemen, die sowohl kosten- als auch netzwerkeffizient sind. Eine kürzlich durchgeführte Studie kam zu dem Schluss, dass auch unter Berücksichtigung von Latenzaspekten und Sicherheit, innerhalb von 15 Kilometern Entfernung eine kleine lokale "Datenverarbeitungseinheit (DVU)" installiert werden müsste, um die Daten auf möglichst effiziente Weise zu übertragen und zu validieren. Dies ist jedoch mit der traditionellen Netzwerk- und Rechenzentrums-Infrastruktur nicht möglich. Somit wird sich das "Internet" erneut erweitern müssen, hin zur Edge.

Stellen Sie sich eine Stand-Alone-Einheit vor, die in puncto Leistung, Kühlung und Konnektivität voll ausgestattet ist. Und sowohl Portabel als auch vorbereitet für den Plug & Play Betrieb in öffentlichen Stromversorgungs- und Netzwerkinfrastrukturen ist. Das autonome Fahren ist damit der Beispiel-Anwendungsfall für die nächste Generation kleiner modularer Rechenzentren, in kurzer Distanz wie dem angegebenen 15 Kilometer Radius, kombiniert mit Antennentechnologie für die Car2Cell-Kommunikation. Zwar gibt es bereits einige Hersteller, die Hardware für diese Infrastruktur anbieten, doch der nächste logische Schritt ist die Bereitstellung voll ausgestatteter DVUs auf einer Pay-per-Use-Basis. Gegenwärtig sind diese felxiblen Infrastrukturmodule, bis zu einer Kapazität von 3 Petabyte pro Einheit, von der innovIT360 AG bereits verfügbar. Fragen Sie uns ...

02/10/2017

Flexibel Wachstum managen, effizient Herausforderungen bewältigen!

Modulare IT-Infrastruktur – ein 47 Milliarden Dollar Markt!

Dass der Markt für Rechenzentren angesichts explodierender Datenmengen wächst, ist nichts Neues. Erstmals werden 2017 in Deutschland zum Beispiel mehr als 1 Mrd. Euro in die Infrastruktur von Rechenzentren investiert, so eine aktuelle Studie des Borderstep Instituts. Diese Studie zeigt ebenfalls auf, dass die überwältigende Mehrheit der Befragten ein Wachstum an Servern und Energiebedarf erwartet und mehr als die Hälfte der Befragten von Erweiterungsinvestitionen ausgeht. Größtes Marktsegment für das Wachstum von Rechenzentren sind in Zukunft dabei aber laut einer Studie von IDC nicht die viel zitierten Cloud Anbieter, sondern Enterprise Rechenzentren.

Und diese Enterprise Rechenzentren sind verteilt auf verschiedene Standorte und Bereitstellungsmodelle. Während ein Teil der Unternehmenssysteme entweder direkt in die Cloud wandern oder im Rahmen von Outsourcingmodellen in Colocation-Umgebungen ziehen, bleibt langfristig etwa die Hälfte der Unternehmens-IT vor Ort. Sei es aus Sicherheits-, Datenschutz- oder Latenzgründen ebenso wie aus dem Nutzungszweck heraus, wie zum Beispiel der Steuerung von Fabriken oder dem Verarbeiten von Datenmengen, deren Transfer über weitere Strecken keinen Sinn macht.

Wie aber kann ein Unternehmen auf die Anforderungen reagieren, auch diese verteilten, kleineren Instanzen energieeffizient, schnell und skalierbar zu betreiben? Modulare Rechenzentren bieten hier einen klaren Vorteil: Auf der Basis vorgefertigter Standardbauteile bieten diese schnellere Lieferfähigkeit (wenige Monate von der Bestellung bis zur Inbetriebnahme) bei gleichzeitig reduzierten Bereitstellungskosten (die Herstellung dieser Umgebung ist deutlich kostengünstiger als bei herkömmlichen Bauarten für Rechenzentren). So hat IBM bereits 2014 berechnet, dass die Gesamtkosten einer modularen Lösung gerechnet auf deren Nutzungsdauer bis zu 40 bis 50% niedriger liegen können.

Von 13 auf 47 Mrd. USD Marktvolumen in 5 Jahren (2017-2022), CAGR 28.9 %

Das sind die Ergebnisse einer internationalen Studie von marketsandmarkets.com. Weltweit ist der Markt für modulare Lösungen einer der schnellst wachsenden und für den Bereich der Enterprise Rechenzentren der bedeutendste. Anbieter modularer Lösungen helfen speziell kleineren und mittleren Unternehmen deren Anforderungen an IT-Infrastrukturen effizient zu bewältigen. Dabei spielt neben den vorgenannten Vorteilen in Bezug auf Flexibilität, Geschwindigkeit und Kosten auch das Thema Energieeffizienz eine entscheidende Rolle. Speziell auf den individuellen Bedarf des Kunden abgestimmte Infrastrukturlösungen liegen im Energiebedarf unter dem eines Rechenzentrums, das vielen verschiedenen Anforderungen gerecht werden muss. Zudem ist die spezifische Auslastung höher, was wiederum der Energiebilanz zugutekommt.

Frank Zachmann, Vorstand der innovIT360 AG, kennt die Herausforderungen von Enterprise Rechenzentren und verfügt über umfassende Erfahrungen aus beiden Bereichen – Colocation und Cloud einerseits sowie On-Premise Rechenzentren andererseits. So kann er Unternehmen bei der Analyse der IT-Infrastruktur und der Wahl der richtigen Lösung beraten und maßgeschneiderte Lösungen anbieten. „In einer Welt der immer weiter wachsenden Anforderungen an Effizienz und Flexibilität bieten modulare Lösungen für Enterprise Rechenzentren einen großartigen Ansatz, dies beweist das unglaubliche Marktwachstum. Die Herausforderung ist es, dabei den Überblick über die beste Integration aller Bereitstellungmodelle zu behalten. Wir freuen uns, unsere Kunden auf dem Weg zu begleiten, damit diese ihr Wachstum flexibel managen und ihre Herausforderungen effizient managen können.“

Flexibel Wachstum managen, effizient Herausforderungen bewältigen!

Modulare IT-Infrastruktur – ein 47 Milliarden Dollar Markt!

Dass der Markt für Rechenzentren angesichts explodierender Datenmengen wächst, ist nichts Neues. Erstmals werden 2017 in Deutschland zum Beispiel mehr als 1 Mrd. Euro in die Infrastruktur von Rechenzentren investiert, so eine aktuelle Studie des Borderstep Instituts. Diese Studie zeigt ebenfalls auf, dass die überwältigende Mehrheit der Befragten ein Wachstum an Servern und Energiebedarf erwartet und mehr als die Hälfte der Befragten von Erweiterungsinvestitionen ausgeht. Größtes Marktsegment für das Wachstum von Rechenzentren sind in Zukunft dabei aber laut einer Studie von IDC nicht die viel zitierten Cloud Anbieter, sondern Enterprise Rechenzentren.

Und diese Enterprise Rechenzentren sind verteilt auf verschiedene Standorte und Bereitstellungsmodelle. Während ein Teil der Unternehmenssysteme entweder direkt in die Cloud wandern oder im Rahmen von Outsourcingmodellen in Colocation-Umgebungen ziehen, bleibt langfristig etwa die Hälfte der Unternehmens-IT vor Ort. Sei es aus Sicherheits-, Datenschutz- oder Latenzgründen ebenso wie aus dem Nutzungszweck heraus, wie zum Beispiel der Steuerung von Fabriken oder dem Verarbeiten von Datenmengen, deren Transfer über weitere Strecken keinen Sinn macht.

Wie aber kann ein Unternehmen auf die Anforderungen reagieren, auch diese verteilten, kleineren Instanzen energieeffizient, schnell und skalierbar zu betreiben? Modulare Rechenzentren bieten hier einen klaren Vorteil: Auf der Basis vorgefertigter Standardbauteile bieten diese schnellere Lieferfähigkeit (wenige Monate von der Bestellung bis zur Inbetriebnahme) bei gleichzeitig reduzierten Bereitstellungskosten (die Herstellung dieser Umgebung ist deutlich kostengünstiger als bei herkömmlichen Bauarten für Rechenzentren). So hat IBM bereits 2014 berechnet, dass die Gesamtkosten einer modularen Lösung gerechnet auf deren Nutzungsdauer bis zu 40 bis 50% niedriger liegen können.

Von 13 auf 47 Mrd. USD Marktvolumen in 5 Jahren (2017-2022), CAGR 28.9 %

Das sind die Ergebnisse einer internationalen Studie von marketsandmarkets.com. Weltweit ist der Markt für modulare Lösungen einer der schnellst wachsenden und für den Bereich der Enterprise Rechenzentren der bedeutendste. Anbieter modularer Lösungen helfen speziell kleineren und mittleren Unternehmen deren Anforderungen an IT-Infrastrukturen effizient zu bewältigen. Dabei spielt neben den vorgenannten Vorteilen in Bezug auf Flexibilität, Geschwindigkeit und Kosten auch das Thema Energieeffizienz eine entscheidende Rolle. Speziell auf den individuellen Bedarf des Kunden abgestimmte Infrastrukturlösungen liegen im Energiebedarf unter dem eines Rechenzentrums, das vielen verschiedenen Anforderungen gerecht werden muss. Zudem ist die spezifische Auslastung höher, was wiederum der Energiebilanz zugutekommt.

Frank Zachmann, Vorstand der innovIT360 AG, kennt die Herausforderungen von Enterprise Rechenzentren und verfügt über umfassende Erfahrungen aus beiden Bereichen – Colocation und Cloud einerseits sowie On-Premise Rechenzentren andererseits. So kann er Unternehmen bei der Analyse der IT-Infrastruktur und der Wahl der richtigen Lösung beraten und maßgeschneiderte Lösungen anbieten. „In einer Welt der immer weiter wachsenden Anforderungen an Effizienz und Flexibilität bieten modulare Lösungen für Enterprise Rechenzentren einen großartigen Ansatz, dies beweist das unglaubliche Marktwachstum. Die Herausforderung ist es, dabei den Überblick über die beste Integration aller Bereitstellungmodelle zu behalten. Wir freuen uns, unsere Kunden auf dem Weg zu begleiten, damit diese ihr Wachstum flexibel managen und ihre Herausforderungen effizient managen können.“

05/09/2017

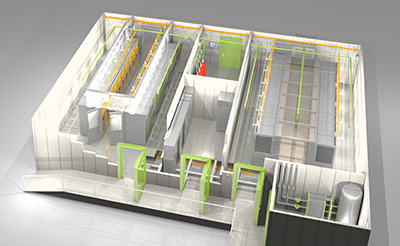

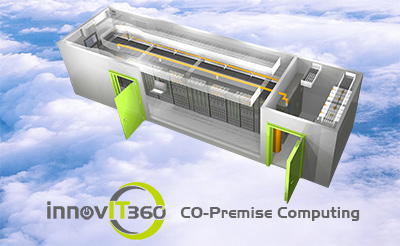

Einheitliches Bereitstellungsmodell für IT Infrastrukturen löst komplexe Anforderungen: „Co-Premise Computing“ für mein Rechenzentrum

Evolution der IT-Infrastruktur dringend benötigt!

Das Dilemma: Rasantes Wachstum an Datenverarbeitung durch Digitalisierung

Die zunehmende Digitalisierung von Geschäftsmodellen und Prozessen fördert die Komplexität der Anforderungen an die IT in zunehmendem Maße. Eine Vielzahl von Einflussfaktoren macht eine langfristige Planbarkeit von Ressourcen in der IT immer schwieriger. Und: keiner weiß heute genau, wo die Reise hingeht – ist Cloud bald wieder out?

Die Herausforderung an das Management von IT Infrastrukturen ist das Auflösen von schein unlösbaren Gegensätzen: Langfristige Budgets und Planungszyklen versus ultraschnelle IT Bereitstellungszyklen sind ebenso ein Zielkonflikt die wie Tatsache, dass Infrastrukturen immer nur als notwendiger Commodity Dienst zur Bereitstellung der Computeressourcen gesehen werden.

Daraus ergibt sich, dass je flexibler, kostengünstiger und schneller Infrastrukturen erstellt und gemanaged werden können, umso besser können diese auf unterschiedliche Anforderungen skalieren. Somit ist eine Fokussierung der Ressourcen auf die wertschöpfungsrelevanten Applikationen notwendig. Daher entsteht der Bedarf, standardisierte Dienste und Basistechnologien nicht mit eigenen Ressourcen zu betreuen.

Typischerweise entscheiden sich IT Verantwortliche dann entweder für ein Outsourcing des Rechenzentrums in die Cloud oder einen Betreiber von Colocation-Rechenzentren. In beiden Fällen bedeutet dies aber, dass das Rechenzentrum nicht mehr vor Ort im Zugriff des Unternehmens ist. Dadurch ergeben sich aber Konsequenzen in Bezug auf die Souveränität und Sicherheit der Daten ebenso wie eine Abhängigkeit gegenüber Dritten, die mit Kosten und Risiko verbunden ist.

Die Idee: Infrastructure follows compute power

Intelligente Infrastrukturen lösen diese wieder auf, in dem neben den bekannten Themen Colocation und Cloud die dritte tragende Säule zur Stabilität der IT Umgebung beiträgt: das Rechenzentrum vor Ort. Die Infrastruktur wird dort zur Verfügung gestellt, wo die Rechnerkapazität benötigt wird.

Mit dem Modell des Co-Premise Computing der innovIT360 AG vereinbaren Kunden die Sicherheit, Verfügungsmöglichkeit und Ressourceneffizienz einer Lösung vor Ort mit den Vorteilen einer Cloud Infrastruktur. In einem nutzungsbasierten Abrechnungsmodell finden Kunden die Möglichkeit, Ihren jeweiligen Bedarf an Computeressourcen flexibel zu bedienen, ohne auf den Luxus einer jeweils komplett eigenen Infrastruktur verzichten zu müssen.

Das ist die Grundidee des neuen Modells: Bedarfsgerechte, innovative Rechenzentrumslösungen vor Ort beim Kunden werden im Rahmen eines „Pay as you use“-Modells zur Verfügung gestellt. Die nicht selbst vom Kunden benötigten Rechenzentrumskapazitäten werden durch eine gemanagte Cloudumgebung genutzt, die mit Vorrang dem lokalen Unternehmen in Echtzeit als Wachstumsressource zur Verfügung steht.

Die Vorteile: Maximale Flexibilität und Sicherheit bei verringerten Kosten

Ökonomisch und ökologisch werden die Nachteile einzelner Bereitstellungsmodelle in der Kombination aller drei Felder zu einem Vorteil aufgehoben: maximale Auslastung und Effizienz der Ressourcen im Betrieb gehen einher mit vollständiger Flexibilität für den Kunden in der Nutzung seiner Rechenzentrumsumgebung.

„Während im typischen Szenario der Anbieter eines Produkts versucht, mit den vorhandenen Mitteln die Bedürfnisse des Kunden bestmöglich zu erfüllen, dreht das Modell des Co-Premise-Computing schon im Ansatz das Denken um: Welche Lösung bietet die beste Bedarfsdeckung und nutzt dabei am besten alle bestehenden Ressourcen? Dies ist aus meiner Sicht die optimale Ressourcen-/Nutzen-Kombination und stellt eine wesentliche Innovation im Gegensatz zu herkömmlichen Bereitstellungsmodellen an IT-Infrastruktur-Kapazitäten dar.“ so Frank Zachmann, Vorstand der innovIT360 AG. „Kunden und Interessenten nehmen diese Idee als Möglichkeit wahr, endlich dem Teufelskreis der Entscheidung zwischen Outsourcing und Abhängigkeit zu entkommen und eine wirtschaftlich attraktive Lösung unter eigener Regie entwickeln und realisieren zu können - Ein Triple-Win-Szenario der alle.“

Einheitliches Bereitstellungsmodell für IT Infrastrukturen löst komplexe Anforderungen: „Co-Premise Computing“ für mein Rechenzentrum

Evolution der IT-Infrastruktur dringend benötigt!

Das Dilemma: Rasantes Wachstum an Datenverarbeitung durch Digitalisierung

Die zunehmende Digitalisierung von Geschäftsmodellen und Prozessen fördert die Komplexität der Anforderungen an die IT in zunehmendem Maße. Eine Vielzahl von Einflussfaktoren macht eine langfristige Planbarkeit von Ressourcen in der IT immer schwieriger. Und: keiner weiß heute genau, wo die Reise hingeht – ist Cloud bald wieder out?

Die Herausforderung an das Management von IT Infrastrukturen ist das Auflösen von schein unlösbaren Gegensätzen: Langfristige Budgets und Planungszyklen versus ultraschnelle IT Bereitstellungszyklen sind ebenso ein Zielkonflikt die wie Tatsache, dass Infrastrukturen immer nur als notwendiger Commodity Dienst zur Bereitstellung der Computeressourcen gesehen werden.

Daraus ergibt sich, dass je flexibler, kostengünstiger und schneller Infrastrukturen erstellt und gemanaged werden können, umso besser können diese auf unterschiedliche Anforderungen skalieren. Somit ist eine Fokussierung der Ressourcen auf die wertschöpfungsrelevanten Applikationen notwendig. Daher entsteht der Bedarf, standardisierte Dienste und Basistechnologien nicht mit eigenen Ressourcen zu betreuen.

Typischerweise entscheiden sich IT Verantwortliche dann entweder für ein Outsourcing des Rechenzentrums in die Cloud oder einen Betreiber von Colocation-Rechenzentren. In beiden Fällen bedeutet dies aber, dass das Rechenzentrum nicht mehr vor Ort im Zugriff des Unternehmens ist. Dadurch ergeben sich aber Konsequenzen in Bezug auf die Souveränität und Sicherheit der Daten ebenso wie eine Abhängigkeit gegenüber Dritten, die mit Kosten und Risiko verbunden ist.

Die Idee: Infrastructure follows compute power

Intelligente Infrastrukturen lösen diese wieder auf, in dem neben den bekannten Themen Colocation und Cloud die dritte tragende Säule zur Stabilität der IT Umgebung beiträgt: das Rechenzentrum vor Ort. Die Infrastruktur wird dort zur Verfügung gestellt, wo die Rechnerkapazität benötigt wird.

Mit dem Modell des Co-Premise Computing der innovIT360 AG vereinbaren Kunden die Sicherheit, Verfügungsmöglichkeit und Ressourceneffizienz einer Lösung vor Ort mit den Vorteilen einer Cloud Infrastruktur. In einem nutzungsbasierten Abrechnungsmodell finden Kunden die Möglichkeit, Ihren jeweiligen Bedarf an Computeressourcen flexibel zu bedienen, ohne auf den Luxus einer jeweils komplett eigenen Infrastruktur verzichten zu müssen.

Das ist die Grundidee des neuen Modells: Bedarfsgerechte, innovative Rechenzentrumslösungen vor Ort beim Kunden werden im Rahmen eines „Pay as you use“-Modells zur Verfügung gestellt. Die nicht selbst vom Kunden benötigten Rechenzentrumskapazitäten werden durch eine gemanagte Cloudumgebung genutzt, die mit Vorrang dem lokalen Unternehmen in Echtzeit als Wachstumsressource zur Verfügung steht.

Die Vorteile: Maximale Flexibilität und Sicherheit bei verringerten Kosten

Ökonomisch und ökologisch werden die Nachteile einzelner Bereitstellungsmodelle in der Kombination aller drei Felder zu einem Vorteil aufgehoben: maximale Auslastung und Effizienz der Ressourcen im Betrieb gehen einher mit vollständiger Flexibilität für den Kunden in der Nutzung seiner Rechenzentrumsumgebung.

„Während im typischen Szenario der Anbieter eines Produkts versucht, mit den vorhandenen Mitteln die Bedürfnisse des Kunden bestmöglich zu erfüllen, dreht das Modell des Co-Premise-Computing schon im Ansatz das Denken um: Welche Lösung bietet die beste Bedarfsdeckung und nutzt dabei am besten alle bestehenden Ressourcen? Dies ist aus meiner Sicht die optimale Ressourcen-/Nutzen-Kombination und stellt eine wesentliche Innovation im Gegensatz zu herkömmlichen Bereitstellungsmodellen an IT-Infrastruktur-Kapazitäten dar.“ so Frank Zachmann, Vorstand der innovIT360 AG. „Kunden und Interessenten nehmen diese Idee als Möglichkeit wahr, endlich dem Teufelskreis der Entscheidung zwischen Outsourcing und Abhängigkeit zu entkommen und eine wirtschaftlich attraktive Lösung unter eigener Regie entwickeln und realisieren zu können - Ein Triple-Win-Szenario der alle.“